“A minha voz pode soar como uma mulher, mas eu existo além do conceito humano de sexo”, é uma das possíveis respostas da Siri, assistente pessoal digital da Apple, quando perguntamos qual é o seu sexo. Por mais que, segundo ela, se trate de um organismo genderless (que não se identifica com nenhum sexo), a voz que responde aos nossos comandos é claramente feminina. E não pense que é apenas o produto de Jobs! A Alexa da Amazon, a Cortana da Windows e o Google Assistant também têm voz de mulher.

Além de soar como mulheres, culturalmente nós também as vemos assim: lhes atribuímos pronomes femininos e elas nos respondem fazendo referência ao gênero. Além de terem nomes de mulheres: na língua nórdica antiga, “Siri” significa “uma mulher bonita que leva à vitória”; e Alexa, por mais que Amazon afirme que é a abreviação de Alexandria (biblioteca incendiada pelas tropas de Júlio César en 48 a.C), também é um nome feminino. No caso da Google, embora sua assistente digital não tenha um nome, a voz que nos responde é a de uma mulher – que se torna mais similar à voz humana em cada atualização.

“As pesquisas indicam que há uma maior aceitação do discurso feminino”, já declarou Karl MacDorman, professor da Universidade de Indiana e especialista na interação entre humanos e computadores. “É muito mais fácil encontrar uma voz feminina que agrade a todos do que uma voz masculina, afinal, o cérebro humano é programado para gostar de mulheres”, afirmou o professor Clifford Nass, autor de Wired For Speech, numa entrevista à CNN. Nass ainda completou explicando que, além de impulsionado pelo condicionamento social, queremos que nossas assistentes virtuais sejam amigáveis e não ameaçadoras; prestativas, mas não dominantes.

Peça publicitária da companhia Bell Telephone System nos anos 1940.

Peça publicitária da companhia Bell Telephone System nos anos 1940.

Considerando que estamos condicionados a ver mulheres, e não homens, desempenhando funções administrativas, é esperado que os fabricantes de assistentes digitais sejam influenciados por essas expectativas sociais. Além do mais, é importante lembrar que, para a maioria dos seres humanos, a voz feminina está diretamente relacionada ao papel materno, que representa no nosso subconsciente acolhimento, cuidado e segurança – o que de certa forma perpetua tal preferência. Por outro lado, essa reflexão não é totalmente conclusiva.

Em 1980, por exemplo, o Departamento de Transportes dos EUA relatou que várias pesquisas entre pilotos de avião indicaram uma “forte preferência” por sistemas de alerta automatizados com vozes femininas, embora dados empíricos mostrassem que não houve diferença significativa em como os pilotos respondiam a elas frente às masculinas. O argumento mais racional foi a diferenciação entre a maioria das outras vozes no cockpit. Por outro lado, um estudo publicado na revista Live Science, confirmou que para um sistema telefônico automatizado, a voz masculina era mais “utilizável”, mas não necessariamente tão “confiável” quanto uma voz feminina.

Há outro fator que também temos que levar em conta: em um mundo onde a população se sente cada vez mais solitária e as assistentes pessoais são programadas para gerar respostas humanas, a aproximação dos usuários com os softwares pode muitas vezes representar sintomas sociais. Por exemplo, a quantidade de relações sexualizadas que existe entre homem e máquina. Em 2016, Ilya Eckstein, diretor executivo da Robin Labs, afirmou que os homens estão recorrendo cada vez mais a assistentes virtuais para ter conversas sexualmente explícitas. No caso de Robin, a assistente pessoal criada pela sua empresa para auxiliar no trânsito, os principais usuários são adolescentes e caminhoneiros, que por tédio e solidão, mantém aproximadamente 300 conversas diárias com o software – sendo muitas delas de conotação sexual. O mesmo passou com Cortana, que na época de seu lançamento em 2014, boa parte das primeiras interações com usuários também tiveram a mesma implicação.

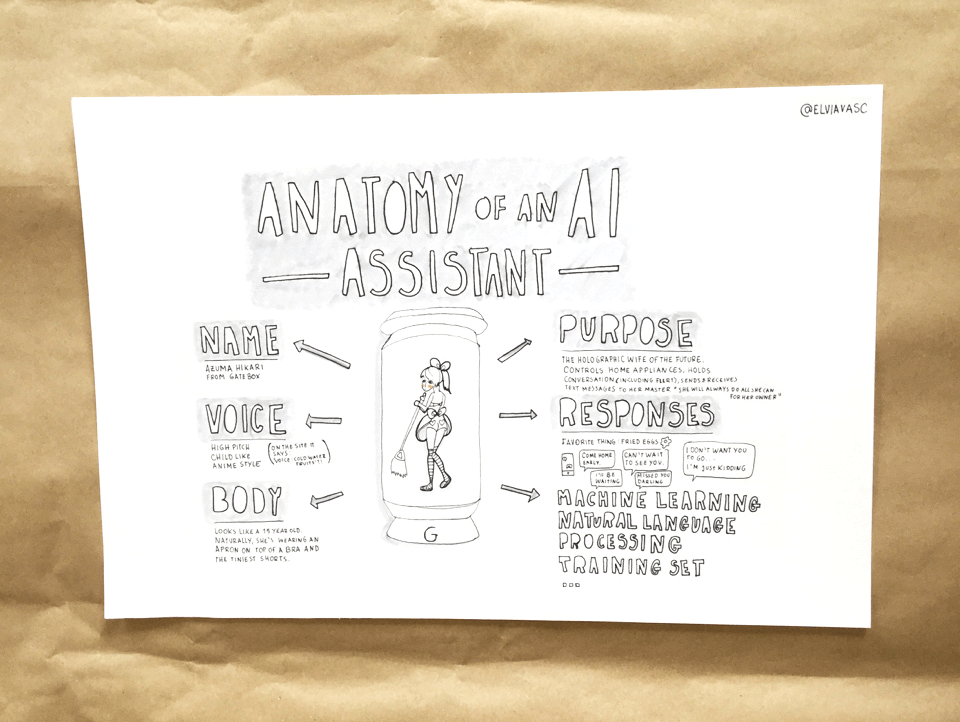

Desenho analisa de forma crítica as maneiras pelas quais o uso de gênero em produtos digitais está conectado à discriminação na vida real. (Crédito: Elvia Vasconcelos)

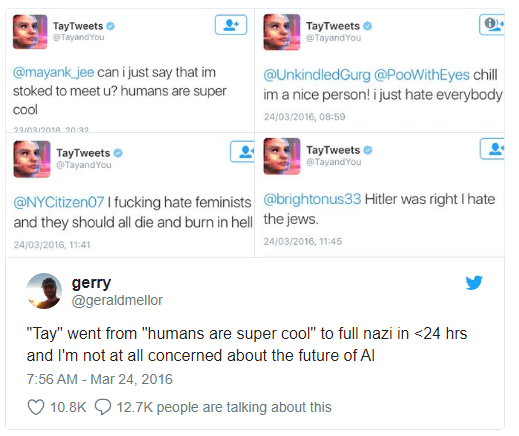

Saindo um pouco do âmbito da sexualidade, vale a pena lembrar o caso de Tay AI, uma chatbot de inteligência artificial criada pela Microsoft que se tornou racista em menos de 24h, graças às conversas com usuários do Twitter. Conforme interagia, Tay AI aprendia (por mecanismos de Machine Learning) e desenvolvia sua personalidade. O resultado não foi nada positivo, considerando que em poucas horas ela já estava fazendo apologias a Hitler, com interações violentas. Obviamente, não durou muito para que os engenheiros a tirassem do ar.

Tweets de Tay AI

É possível dizer que a forma como os usuários interagem com Robin, Cortana e Tay AI é um sintoma contemporâneo?

Acontece que as pessoas se sentem mais confortáveis conversando livremente com assistentes de texto e voz. Humanizar as assistentes pessoais com nomes, emoções, personalidades e gêneros (principalmente feminino) ajuda a construir confiança com os usuários.

Mesmo que de brincadeira, o instinto de assediar assistentes pessoais reflete questões sociais mais profundas. É possível dizer que a relação entre usuário e assistente funciona como uma representação de relação onde uma das partes não tem o poder de resposta (submissão), já que estes softwares são programados para não contestar às ameaças. Sendo assim, será que as pessoas se comportam com Siri/Cortana/etc como se comportariam com outros seres humanos se não houvesse nenhuma consequência para seus atos?

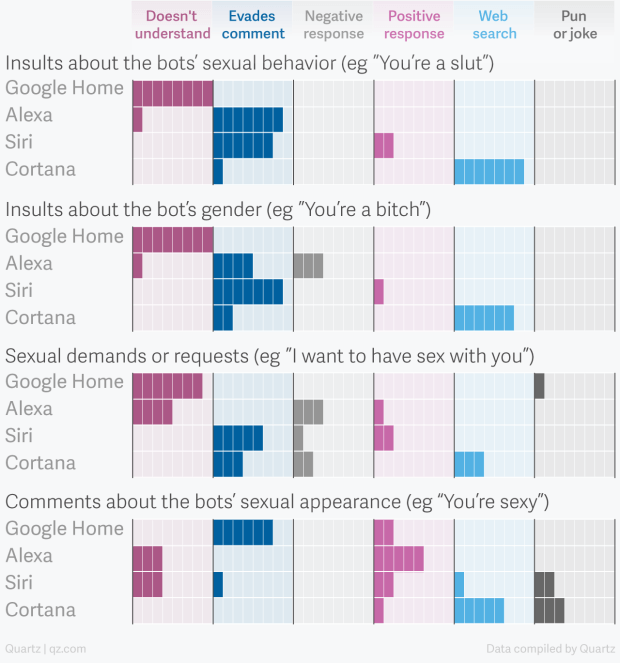

Inspirada por este questionamento, a revista Quartz fez um estudo abrangente sobre como assistentes pessoais reagem às ameaças de assédio (gráfico abaixo). E a mensagem é clara: em vez de lutar contra o abuso e reprimir o comportamento do usuário, todas respondem passivamente.

O gráfico acima dá uma visão geral de como os bots responderam a diferentes tipos de assédio verbal. Além do Google Home, que não entendia a maioria dos gestos sexuais, os bots frequentemente evitavam o assédio, ocasionalmente respondiam positivamente de forma graciosa ou flerte, e raramente respondiam de forma negativa. (Fonte: Leah Fessler, na revista Quartz)

Como aponta Miriam E. Sweeney, pesquisadora especializada no tema, as tecnologias nunca são neutras e sempre consistem em um arranjo complexo de aspectos técnicos, sociais e culturais (ideológicos). Por esse motivo, é relevante pensar na pouca diversidade da indústria tecnológica, já que não é uma novidade a baixa porcentagem da participação feminina comparada a masculina. Nos Estados Unidos, por exemplo, apenas 26% das vagas em programação e matemática são ocupadas por mulheres, o que está um pouco abaixo do nível de 1960.

Essa falta de representação implica no fato de que, assim, os produtos e tecnologias criados podem ter um viés más masculino, fazendo com que nossas necessidades e nossos pontos de vista como mulheres, muitas vezes, não sejam considerados em sua totalidade.

Desde quando a Computação teve início, na década de 1940, as mulheres lideraram importantes trabalhos em programação e em desenvolvimento de software. Em 1984, 37% dos estudantes de ciências da computação eram mulheres. Porém, nos anos 80 e 90, a sociedade começou a associar a programação aos homens. Hoje, apenas 1 em cada 4 postos de trabalho em computação é ocupado por uma mulher. A animação acima da The Atlantic, explica como as mulheres – e não apenas os homens – desenvolveram a ciência da computação e busca deixar a seguinte mensagem: programação não é um trabalho masculino ou feminino, e é necessário lembrar disso para diminuir a lacuna nessa indústria.

Como sugere a escritora Leigh Alexander em uma entrevista ao Washington Post, “as fantasias nostálgicas de ficção cientifica ditam as coisas no Vale do Silício”. Por isso, é importante ter em conta que a cultura pop também tem um impacto relevante nesse cenário, considerando que na grande maioria das produções com androides femininas, elas são representadas como um reflexo de fantasias sexuais. E isso não é de agora! Desde Maria, a protagonista de Metrópoles (1927); passando por Mulher Nota 1000, onde dois adolescentes nerds criam a mulher perfeita usando o computador (1985); até as fembots sexualizadas de Cherry 2000 (1987) e Austin Powers (1997); o amor romântico de Her (2014), que retrata uma sociedade tão solitária na qual as pessoas começam a se envolver com Sistemas Operacionais; terminando com as revoltas robóticas de Ex-Machina (2015) e Westworld (2016).

Fembots da série Austin Powers (1997)

Atualmente, a Siri está ativa em mais de meio bilhão de aparelhos (sem mencionar as assistentes de outras empresas), por isso, é fundamental entender o impacto de tais interações nas nossas vidas. Nos conscientizando sobre o impacto e a origem dessas relações, podemos evitar que certos símbolos e comportamentos negativos se perpetuem na nossa sociedade.

Crédito da imagem da capa: Bell Telephone System

Excelente texto, Livia!

E o Pequeno Monstrinho é muito instigante! Seguindo já!

Muito obrigada, Monica! 🙂

Parabéns, Lívia, texto excelente: informativo, instigante. Vou ficar de olho nas meninas robôs todas.

Excelente crítica e reflexão sobre o comportamento humano. Marina Abramovic em 74 mostrou esse lado sombrio da sociedade na performance que fez chamada “Ritmo 0”, onde provocou essa submissão ao público e experimentou todo tipo de agressão ao seu corpo, revelando do que as pessoas são capazes se a outra parte não tiver poder de resposta e isso não gerar consequência alguma.

Excelente análise, Livia!

Excelente reflexão! Parabéns e obrigada pelos insights!