Mais um passo em direção a um dia ser possível criar “personas” digitais, totalmente interativas e tridimensionais a partir de um acervo de fotos, vídeos ou outros recursos visuais existentes.

Pesquisadores da Universidade de Washington demonstraram que é possível, com a ajuda dos algoritmos de aprendizado da máquina (ou machine learning), capturar a “persona” de alguém, ou seja, sua aparência física e seu comportamento, e criar um modelo digital dela, a partir de suas fotos.

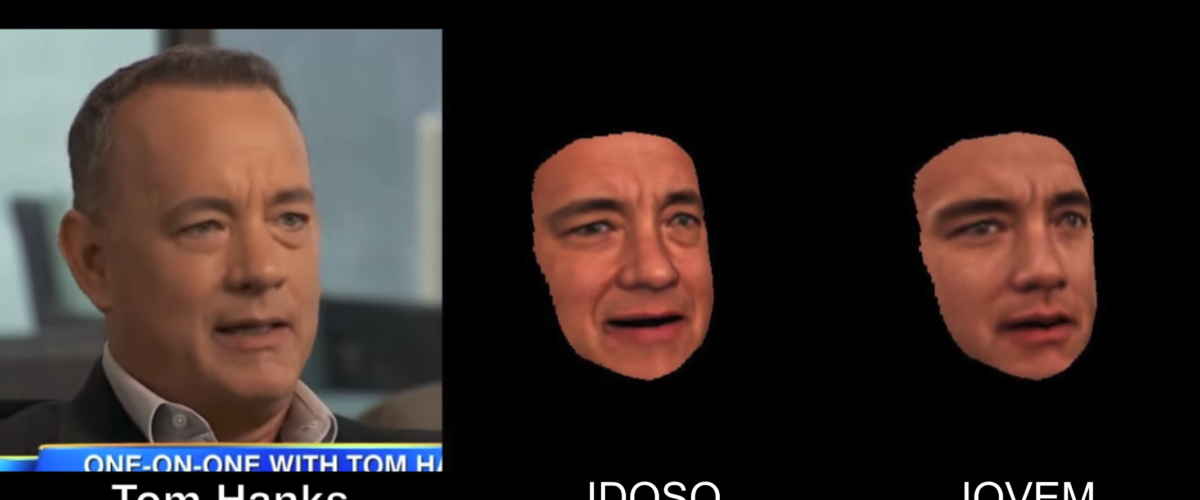

Como demonstração, um dos escolhidos foi o ator Tom Hanks que possui inúmeras imagens disponíveis na Internet. Então, com dados visuais suficientes para minerar, os algoritmos puderam animar o modelo digital do ator, colocando uma fala, que ele, na realidade, nunca falou.

Ao longo dos anos, Tom Hanks atuou em diversos papéis, seja como jovem, idoso, inteligente, rude, etc. No entanto, nós sempre o reconhecemos como sendo ele. Por que isso acontece? É a sua aparência? Suas expressões? Gestos? Ou a maneira como ele se movimenta?

Uma resposta para o que faz Tom Hanks se parecer com Tom Hanks pode ser demonstrada com um sistema computacional que imita o que ele vai fazer, explica o autor do estudo, Supasorn Suwajanakorn.

https://www.youtube.com/embed/ladqJQLR2bA

Essa nova tecnologia baseia-se em avanços na reconstrução em 3D do rosto, alinhamento, modelagem em multi-textura, etc. A tecnologia foi desenvolvida ao longo dos últimos cinco anos por um grupo de pesquisadores liderado por Ira Kemelmacher-Shlizerman, professora assistente de Ciência da Computação e Engenharia na UW. Os novos resultados estão num paper de acesso aberto e serão apresentados na Conferência Internacional sobre Visão Computacional no Chile, na próxima semana, 16 de dezembro.

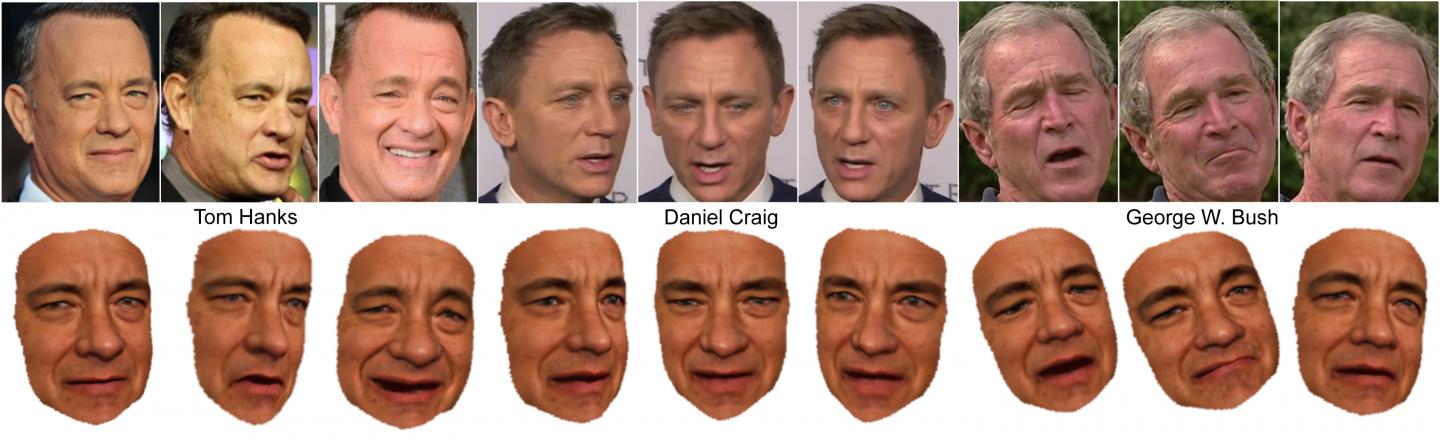

Os mais recentes avanços dessa equipe incluem a capacidade de transferir expressões e o modo como determinada pessoa fala “em cima” do rosto de outra pessoa – por exemplo, o mapeamento de “maneirismos” do ex-presidente George W. Bush sobreposto nos rostos de outros políticos e celebridades.

A medida que as tecnologias de Realidade Virtual e Realidade Aumentada evoluem, será possível usar fotografias de família e vídeos para criar um modelo interativo de um parente no exterior, ao invés de simplesmente conversar por Skype com ele em duas dimensões. Ou seja, a tecnologia de reconstrução é mais um passo.

“Você poderá um dia colocar um par de óculos de realidade aumentada e ter um modelo 3D de sua mãe no sofá”, Kemelmacher-Shlizerman, autor sênior.

O co-autor do estudo, Steve Seitz também nos faz imaginar como seria ter uma conversa com alguém que você não pode encontrar-se pessoalmente – como Barack Obama ou Charlie Chaplin – e interagir com eles.

Para Seitz isso será possível, e eles estão tentando chegar lá através de uma série de etapas da pesquisa. Um dos verdadeiros testes será ter estas “personas” dizendo coisas que elas não disseram, mas ainda como se fosse elas. Ou seja, mapear o desempenho de uma pessoa no rosto de outra pessoa, sem perder a sua identidade.

“Nós demonstramos que podemos ter expressões, boca e movimentos de George Bush, mas ele ainda se parecendo com George Clooney”. Steve Seitz, co-autor do estudo.

Este trabalho irá demonstrar essa capacidade, e é a parte mais interessante de tudo, acredita Seitz.

Benjamim Button seria criado em casa

Brad Pitt no filme Benjamin Button

As tecnologias que hoje existem para criar hologramas tridimensionais detalhados ou personagens de filmes como Benjamin Button dependem de trazer uma pessoa para um estúdio. Eles meticulosamente capturam todos os ângulos da pessoa e a forma como ela se move – algo que não pode ser feito em casa.

Outras técnicas ainda precisam que a pessoa seja “scanneada” digitalmente, por exemplo para criar um avatar para jogos de vídeo ou outros ambientes virtuais. Mas, os especialistas da UW queriam reconstruir digitalmente uma pessoa com base unicamente em uma coleção aleatória de imagens existentes.

Aprender em estado selvagem

Para reconstruir celebridades como Tom Hanks, Barack Obama e Daniel Craig, os algoritmos de aprendizado de máquina utilizaram um mínimo de 200 imagens da Internet – fotos tiradas ao longo do tempo em vários cenários e poses – num processo conhecido como aprendizagem “in the wild”.

O que a equipe fez foi utilizar apenas fotos da Internet ou uma coleção de fotos de uma pessoa e animar um modelo sem necessidade dela interagir com uma câmera. Ao longo dos anos eles criaram algoritmos que trabalham com este tipo de dados sem restrições.

Suwajanakorn mais recentemente desenvolveu técnicas para capturar expressões com pequenas diferenças que ocorrem quando uma pessoa sorri ou olha de forma intrigada ou muda a sua boca, por exemplo.

Ao manipular as condições de iluminação em diferentes fotografias, eles desenvolveram uma nova abordagem para mapear densamente as diferenças de características e expressões de uma pessoa no rosto de outra pessoa. Esse avanço permite que a equipe “controle” o modelo digital com um vídeo de outra pessoa, potencialmente permitindo uma série de novas animações e aplicações de realidade virtual.

Quem sabe essa tecnologia possa em breve ser usada para criar experiências de realidade virtual em 360 graus…

Fonte: Grail UW