Tecnologia e guerra sempre tiveram um relacionamento complicado, até um pouco irônico às vezes. Primeiro, foi a pólvora. Por volta do ano 850, os chineses experimentavam elixires que pudessem estender suas vidas. A busca pela imortalidade levou à invenção da arma mais mortal de todo um milênio.

Depois, foram as armas nucleares. Com o objetivo de acabar com a maior guerra que a humanidade viveu, a levamos à beira de sua destruição. A ironia da situação assustou o mundo. Deu início a uma era em que potências nucleares não mais lutam diretamente entre si, mas, financiam guerras entre outros países, se enfrentando indiretamente. Ou então, lutam apenas com aqueles que não as possuem. Uma Era em que o paradoxo da destruição mutuamente assegurada “funcionou” e em que, para fugir da destruição e da invasão, tornou-se necessário construir a pior das armas.

Convivemos diariamente com os efeitos dessas duas invenções. O uso e o controle de revólveres, fuzis e metralhadoras ainda é um problema — interno e externo — em grande parte do mundo. E o desenvolvimento de armas nucleares é fator geopolítico determinante da distribuição de poder e conflitos pelo mundo.

Mas, uma relação de tanto tempo não sobrevive só por acidente. Muitos dos mais importantes avanços tecnológicos do último século foram criados em plena guerra — computadores, criptografia, ciência espacial, GPS, internet e até o leite condensado. Para cada uma dessas invenções, o suporte e financiamento de Estados, que precisavam usá-las para ter vantagem em guerra, acabou gerando também resultados benéficos para a humanidade em geral: agora temos smartwatches, missões para Marte, Waze, memes e brigadeiro de colher.

Parece que sempre estamos nesse limiar, em que tecnologia e guerra precisam uma da outra para continuarem existindo. Como um pêndulo que oscila entre “destruição da humanidade” e “civilização extremamente desenvolvida” sem nunca chegar nos extremos, mas nos dando sempre um gostinho do que poderia acontecer se chegássemos. Uma relação extremamente complicada, e é bom que estejamos bem a par dela, porque robôs estão chegando.

O nosso mais novo soldado

Se o uso de robôs no exército terá um resultado tão bom quanto a internet ou tão ruim quanto Hiroshima e Nagasaki, é uma questão ainda em aberto. Como vamos ver, depende muito de nós entendermos o que podemos fazer para dirigir tudo isso para um lado ou para outro. Mas, antes, precisamos analisar o cenário geral: como a robótica permitiu que chegássemos onde estamos e as promessas de uma Era em que não mais lutamos nossas próprias guerras.

Assim como o desenvolvimento teórico da física, no começo do século XX, foi a base da criação de armas nucleares, o desenvolvimento da robótica e da inteligência artificial estão intimamente ligadas à criação de robôs militares. Os dois campos chegaram a um ponto em que tornou-se possível aos robôs terem as características necessárias para executar tarefas complexas em ambientes consideravelmente dinâmicos. Foi uma evolução de décadas. O que vou chamar aqui de “traços” de um sistema nos ajudará a entender o que mudou com o passar dos anos e onde estamos hoje.

Dividiremos esses “traços” em três: capacidade, automação e inteligência.

Capacidade (capability), é a habilidade de executar uma determinada tarefa. Automação, a habilidade de realizar uma tarefa sem controle humano direto. E inteligência, a habilidade de analisar o ambiente, criar cenários de ação e definir probabilisticamente as chances com que esses cenários cumprirão um objetivo pré-determinado.

Olá, Amora

Para entender melhor tudo isso, vamos supor que queremos resolver um problema: ensinar o Amora, um gato ~hipotético~, a não subir em cima da mesa.

Pavlov, Skinner e algumas horas investidas no Animal Planet ensinaram que a melhor forma é borrifar água no Amora sempre que ele tentar subir. Como borrifar água é difícil usando apenas as mãos, criamos um sistema capaz de fazê-lo; um sistema apenas capaz, que executa uma determinada tarefa, e que não pode nem ser chamado de robô. Sem ser automático ou inteligente, é só uma ferramenta: precisa de um humano para comandá-lo e não consegue analisar o ambiente ou criar cenários de ação. Um borrifador de água, por exemplo. Sempre que o Amora subir em cima da mesa, alguém deve borrifar água nele usando essa ferramenta.

Só que ensinar um gato a não subir na mesa é mais complexo que isso. Como às vezes ele fica em casa sozinho e sobe na mesa sem ser visto, o borrifador de água perde grande parte de sua utilidade. Para resolver o problema, o sistema deve ser automático e borrifar água no gato sem que ninguém esteja envolvido.

Daí, vamos para o segundo passo: um borrifador de água capaz e automático, mas que não consegue analisar o ambiente. De minuto em minuto, ele borrifa água em cima da mesa. Pode acertar o gato, mas pode também acertar qualquer outra coisa que estiver ali. Um computador, papéis, comida, pessoas… Eficaz, mas ineficiente, no final das contas.

Para acertar apenas o Amora, o sistema deve ser também inteligente. Deve ter sensores que o possibilitem absorver e analisar dados do ambiente, e um processamento central para que ele chegue em conclusões baseadas nos dados coletados. Talvez um sensor de peso: quando algo com o peso de um gato subir na mesa, ele borrifa. Ou um sensor de movimento e captação de imagem, para que ele saiba onde borrifar. Assim, pode distinguir um gato de uma pessoa ou de um cachorro; pode analisar o ambiente à sua volta e entender quando e qual ação tomar. Quando um sistema torna-se também inteligente — por menor que essa inteligência seja — passamos também a considerá-lo um robô.

Quanto mais inteligente, capaz e automatizado um sistema for, maior são suas possibilidades. Voltando ao gato: como o objetivo inicial era ensinar ao Amora que subir em cima da mesa era errado, talvez nosso robozinho ache que borrifar água não é o melhor a se fazer. Talvez deva-se comprar brinquedos para que ele não queira subir, ou então aplicar choques para gerar resultados mais rápidos. Se juntarmos os três traços básicos, chegamos em uma característica fundamental de todo aspirante a robô: autonomia funcional. Conceitualmente, ela é “a habilidade de compor cenários, selecionar e executar, sozinho, dentre diferentes cursos de ação, aquele que maximiza as chances de atingir seus objetivos, com base em seu conhecimento e entendimento do mundo, de si mesmo e da situação”.

Para maximizar as chances de evitar que o gato suba na mesa, o sistema analisa a situação e o mundo para decidir que um choque é melhor do que água e agir sobre essa decisão informando a um humano sobre as conclusões em que chegou, por exemplo.

Essa autonomia funcional, assim como seus conceitos base, possui níveis. Um sistema pode ter autonomia funcional em algumas situações (jogar água no Amora), ou então em diversas (entender que jogar água não é a melhor maneira, comprar brinquedos direto de um e-commerce, recebê-los em casa e brincar com o gato).

Toda essa história nos mostra o conflito primordial da robótica: Quanto mais complexo o objetivo que o robô deve executar e o ambiente em que ele está inserido, maior deve ser o nível de cada um dos três traços para que ele seja útil naquela situação.

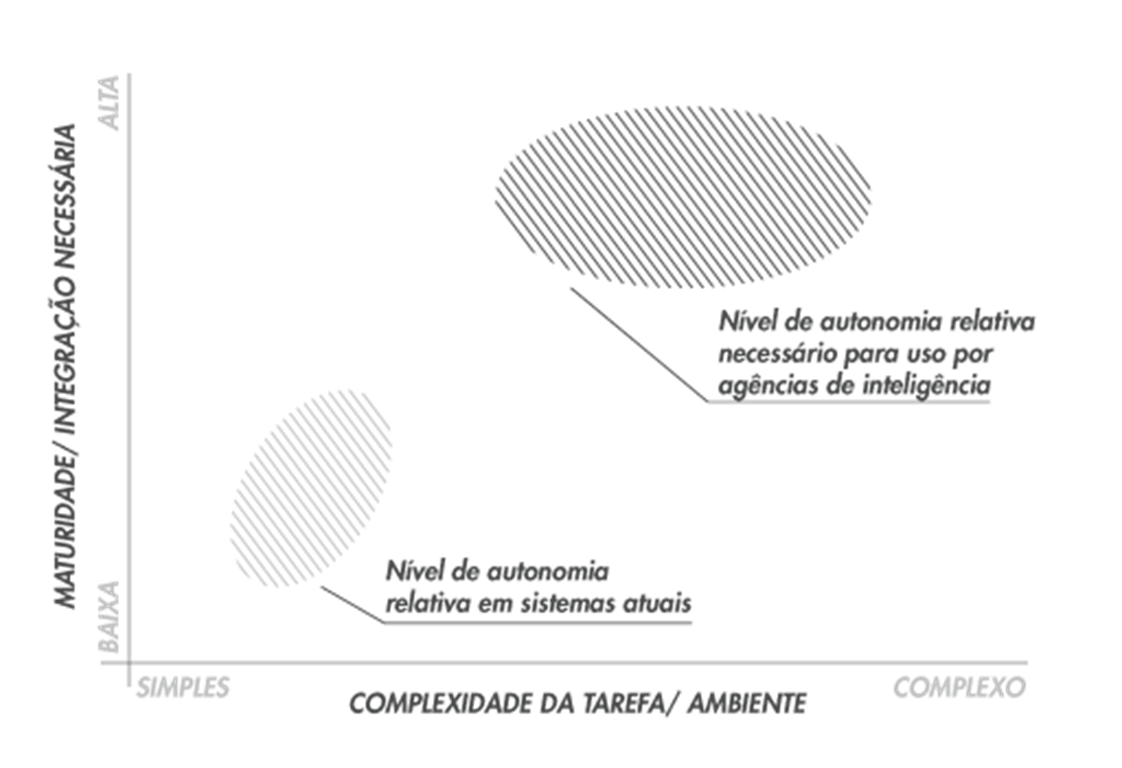

Mas, sejamos realistas. Nossos robôs são militares e nosso ambiente, a guerra. Como o conflito se coloca, nesse caso? A maioria dos relatórios do exército norte-americano — o mais avançado em robótica no mundo — coloca o nível de autonomia e de maturidade tecnológica em um patamar parecido com o do gráfico abaixo, criado pela CIA.

Crédito: CIA – Studies in Intelligence Vol 59, No. 1 (Extracts, March2015)

Portanto, a situação atual é que a tecnologia já está muito avançada, mas não o suficiente para colocarmos robôs autônomos diretamente em guerra ou então em “missões de inteligência”.

Por mais que isso pareça ser um impedimento, existem algumas formas de contornar o descompasso entre complexidade e autonomia.

Numa situação qualquer, quem quer que use um robô pode controlar melhor a situação se puder modificar qualquer um dos dois lados. Ou controlar o ambiente, diminuindo sua complexidade; ou aumentar a autonomia funcional de um robô (mais caro e complicado), possibilitando que ele opere em ambientes mais complexos; ou, ainda, se for realmente necessário que ele opere em situações complexas, terceirizar sua inteligência para um humano.

No próximo artigo, vamos entender um por um esses cenários, analisando melhor a lógica e as consequências do uso de robôs autônomos em guerras reais.